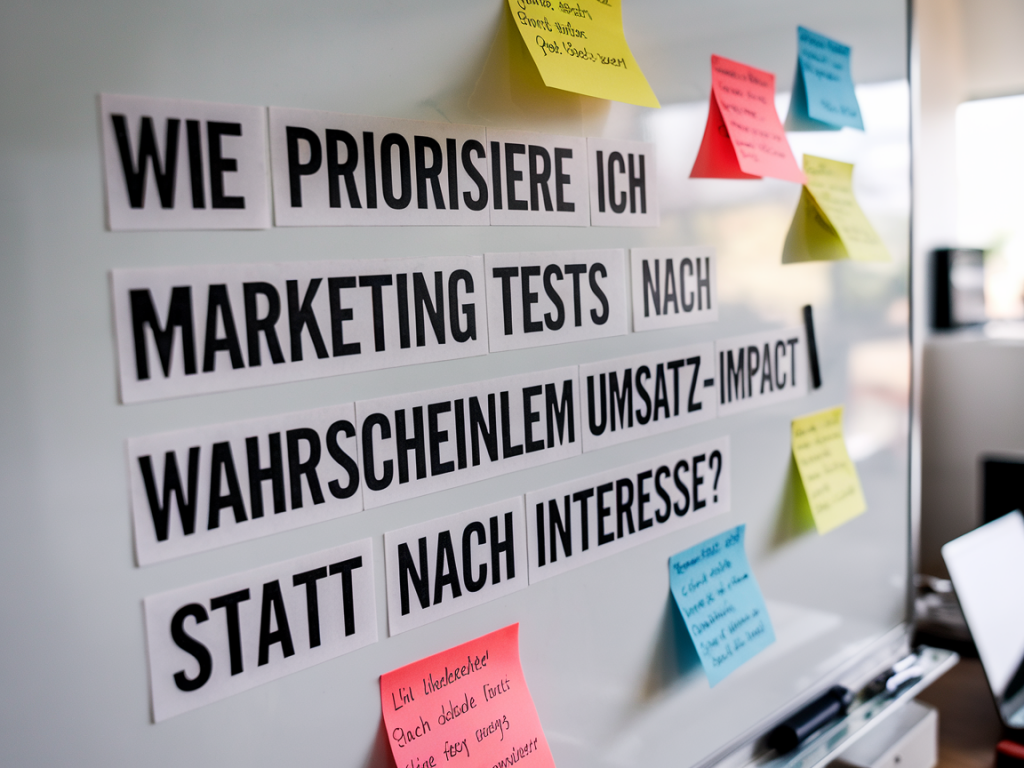

Wenn Teams Marketingtests nach persönlichem Interesse oder dem lautesten Stakeholder priorisieren, endet das oft in vielen netten Ideen — aber wenigen echten Umsatzeffekten. In meinen Projekten habe ich gelernt, Tests so zu priorisieren, dass sie zuerst den wahrscheinlichen Umsatz‑Impact maximieren. Hier beschreibe ich meine pragmatische Methode, die sich leicht in bestehende Testing‑Prozesse integrieren lässt und sofort zu besseren Entscheidungen führt.

Warum Interesse nicht gleich Impact ist

Ich sehe es regelmäßig: ein kreativer Copywriter schlägt A/B‑Tests für die Landingpage Headline vor, ein Product Manager möchte eine neue CTA‑Farbe testen, und das Vertriebsteam drängt auf Content‑Promotion. Alle Vorschläge sind valide — aber nicht gleich wertvoll.

Interesse treibt Ideen an; Impact treibt Umsatz. Tests, die aus Neugier entstehen, liefern oft Insights, aber selten substanzielle Hebel für Umsatz oder Conversion. Mein Ziel ist, die Testpipeline so zu strukturieren, dass wenige, gut ausgewählte Experimente zuerst laufen — jene mit dem höchsten erwarteten Umsatz‑Nutzen.

Grundprinzipien meiner Priorisierung

- Verknüpfe Tests mit Business‑Zielen: Jeder Test braucht eine klare Hypothese, die an Umsatz, MQLs oder Retention gekoppelt ist.

- Schätze wahrscheinlichen Impact und Unsicherheit: Impact ist nicht nur „wie groß könnte das Ergebnis sein“, sondern auch „wie sicher sind wir, dass es wirkt“.

- Berücksichtige Ressourcen und Dauer: Ein schneller Test mit mittlerem Impact kann wertvoller sein als ein monatelanges Projekt mit hohem, aber unsicherem Outcome.

- Nutze einfache Scoring‑Modelle: Datengetriebene Punktevergabe reduziert Bias und macht Entscheidungen nachvollziehbar.

Das einfache Scoring‑Modell, das ich verwende

Ich arbeite gerne mit einem kompakten Score aus vier Dimensionen. Jede Dimension wird 0–5 bewertet und anschließend gewichtet. Die vier Dimensionen sind:

- Geschätzter Umsatz‑Impact (Wie viel zusätzlichen Umsatz könnte der Test realistischerweise bringen?)

- Wahrscheinlichkeit des Erfolgs (Wie sicher sind wir, dass die Hypothese richtig ist?)

- Speed & Kosten (Wie schnell und günstig lässt sich der Test aufsetzen?)

- Skalierbarkeit (Lässt sich ein positiver Effekt einfach hochskalieren?)

Beispielgewichtung, die ich oft nutze: Impact 40%, Wahrscheinlichkeit 30%, Speed 20%, Skalierbarkeit 10%. Die Gesamtpunktzahl ergibt einen Prioritätswert.

| Dimension | Bewertung (0–5) | Gewichtung | Gewichteter Wert |

|---|---|---|---|

| Geschätzter Umsatz‑Impact | 4 | 40% | 1,6 |

| Wahrscheinlichkeit des Erfolgs | 3 | 30% | 0,9 |

| Speed & Kosten | 5 | 20% | 1,0 |

| Skalierbarkeit | 4 | 10% | 0,4 |

| Gesamt | 3,9 |

Wie ich Umsatz‑Impact einschätze (praktisch)

Die schwierigste Dimension ist oft die realistische Einschätzung des Umsatzes. Ich arbeite dabei mit wenigen, pragmatischen Schritten:

- Grundmengen bestimmen: Wie viele Besucher, Leads oder Nutzer erreichen Seiten/Touchpoints aktuell pro Woche/Monat?

- Baseline‑Conversion: Welche Conversion‑Rate liegt aktuell vor (z. B. Demo‑Anmeldungen, Kaufabschlüsse)?

- Realistisches Delta schätzen: Basierend auf Benchmarks, früheren Tests und Komplexität: Ist eine Verbesserung von 5%, 20% oder 50% plausibel?

- Monetarisierung ansetzen: Welcher durchschnittliche Umsatz pro Conversion/Lead ist zu erwarten?

Beispiel: 10.000 Besucher/Monat, Conversion 2% → 200 Conversions. Eine plausible Verbesserung von +25% ergibt +50 Conversions. Bei 500€ durchschnittlichem Kundenwert sind das 25.000€ zusätzlicher Umsatz pro Monat. Das ist ein konkreter Impact‑Wert, mit dem man priorisieren kann.

Beispiele für Tests und ihre typische Priorität

In der Praxis zeigen sich Muster. Hier einige Tests aus meinen Projekten und wie ich sie priorisiert habe:

- Preisanzeige‑Varianten auf Produktseiten: Hoher Impact, da Preis direkt die Kaufentscheidung beeinflusst. Wenn rechtlich/operativ möglich, meist hohe Priorität.

- Onboarding‑Flow Optimierung für Trial‑User: Sehr skalierbar und oft hoher Lebenszeit‑Wert (LTV) Effekt — hohe Priorität, wenn Traffic vorhanden.

- CTA‑Farbe oder Microcopy Tests: Geringe Kosten, aber meist kleiner Impact — guter Quick‑Win, wenn Ressourcen frei sind.

- Neue Feature‑Launch A/B: Potentiell hoher Impact, aber hohe Unsicherheit und Kosten — mittlere bis hohe Priorität, abhängig von Risikoaversion.

Wie man Stakeholder mit dem Modell gewinnt

Entscheidend ist Transparenz. Ich präsentiere jedem Stakeholder die erwarteten Euro‑Beträge und die Wahrscheinlichkeit des Erfolgs. Das klingt banal, aber Geldzahlen schaffen Fokus:

- „Wenn dieser Test wirkt, bringt er voraussichtlich X€ pro Monat bei Y% Wahrscheinlichkeit.“

- „Dieser Quick‑Test kostet Z Stunden und könnte innerhalb 2 Wochen laufen — Break‑even bei nur N zusätzlichen Conversions.“

So werden Emotionen gegen klarere Business‑Argumente ausbalanciert. Außerdem empfehle ich, einen kleinen Anteil der Testkapazität (z. B. 20%) für „Exploratives“ zu reservieren — Raum für Kreativität, ohne den Fokus zu verlieren.

Messbarkeit sicherstellen

Priorisieren nach Umsatz‑Impact funktioniert nur, wenn die Messung sauber ist. Ich achte auf drei Dinge:

- Eindeutige Metriken: Definiert, wie Umsatz/Conversions gemessen werden (UTM, Events, Last‑touch vs. multi‑touch).

- Signifikanz & Laufzeit: Vorher planen, wie lange ein Test laufen muss, um aussagekräftig zu sein.

- Tracking‑Robustheit: Segmentierungs‑Fehler, Bot‑Traffic oder inkonsistente Attribution können Ergebnisse verfälschen — das muss vor Teststart geprüft werden.

Tools & Templates, die ich empfehle

Für die Score‑Berechnung und Ergebnis‑Reporting nutze ich einfache Tools, keine Blackboxen:

- Ein Google Sheet Template zur Score‑Berechnung (Impact/Prob/Speed/Scale) — schnell teilbar mit Stakeholdern.

- A/B‑Testing Tools wie VWO, Optimizely oder Google Optimize (je nach Budget) für Web‑Experimente.

- Analytics: GA4 oder alternativ Matomo — wichtig ist saubere Event‑Definition.

Wenn gewünscht, stelle ich auf Hgd Team ein herunterladbares Template zur Verfügung, das Sie direkt einsetzen können.

Das Ziel ist simpel: weniger Tests, smarter priorisiert, mit klarer Erwartung an Umsatzwirkung und schneller Entscheidungsfähigkeit. So werden Experimente zu echten Hebeln statt zu reinen Wissensbausteinen.